Testy A/B to jedna z najskuteczniejszych metod zwiększania efektywności stron internetowych, kampanii reklamowych czy newsletterów. Dzięki nim można sprawdzić, które elementy przyciągają uwagę użytkowników i skłaniają ich do pożądanego działania. Poniższy artykuł przybliża kluczowe etapy procesu, przedstawia najlepsze praktyki oraz wskazuje, jak wykorzystać wyniki formalnych eksperymentów do optymalizacji wskaźnika konwersji.

Wprowadzenie do testów A/B

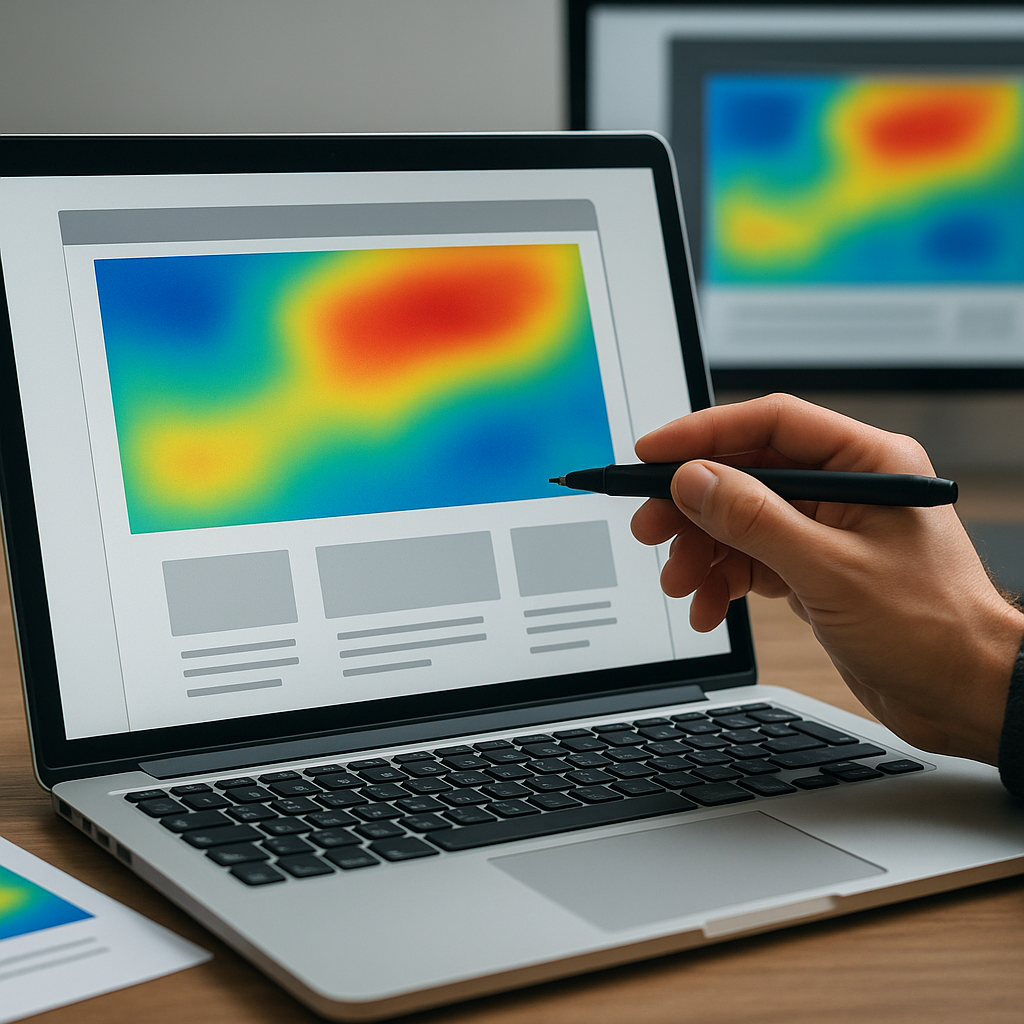

Testy A/B (czasem określane jako split testing) polegają na porównaniu dwóch wersji tej samej strony lub komunikatu, by ustalić, która z nich przynosi lepsze rezultaty. W praktyce dzielimy ruch na dwie grupy – jedną prezentujemy wersję kontrolną (A), a drugiej – zmodyfikowaną (B). Po zebraniu odpowiedniej ilości danych można przejść do analizy statystycznej i wyciągnąć wnioski.

Dlaczego testy A/B przynoszą wymierne korzyści?

- Redukują ryzyko nieprzewidywalnych zmian – zanim wprowadzisz duże modyfikacje, przetestuj je na wybranej grupie.

- Umożliwiają podejmowanie decyzji opartych na danych, a nie przeczuciach czy opiniach jednego marketera.

- Pomagają zoptymalizować UX i CTA, co bezpośrednio przekłada się na wzrost konwersji.

- Wskaźnik ROI staje się bardziej przewidywalny, ponieważ zmiany wprowadzane są stopniowo i na podstawie realnych wyników.

Planowanie i przygotowanie testów

Solidne przygotowanie to podstawa każdego eksperymentu. Bez ścisłej metodyki trudno mówić o rzetelnych wnioskach. Kluczowe etapy obejmują:

1. Definiowanie celu i hipotezy

Na początku ustal, co chcesz osiągnąć. Czy zależy ci na większej liczbie zapisów do newslettera, wyższej liczbie zakupów czy może zwiększeniu czasu przebywania na stronie? Na tej podstawie formułujesz hipotezę, np.: „Zmiana koloru przycisku na czerwony poprawi liczbę kliknięć o co najmniej 10%.”

2. Wybór wskaźników (KPI)

- CTR (Click-Through Rate) – gdy testujesz elementy reklamowe.

- Współczynnik odrzuceń – gdy analizujesz zmiany w architekturze strony.

- Wartość średniego zamówienia – gdy modyfikujesz proces zakupowy.

- Czas na stronie – przy testowaniu treści i układu tekstu.

3. Segmentacja ruchu

Aby wyniki były wiarygodne, warto uwzględnić personalizację i podział na grupy docelowe. Segmentacja może opierać się na:

- Geolokalizacji – różne wersje dla użytkowników z różnych krajów.

- Urządzeniach – testowanie na desktopie vs. mobilnych.

- Źródłach ruchu – kampanie social media, SEO, e-mail marketing.

- Demografii – wiek, płeć, zainteresowania.

4. Wybór narzędzia do testów

Na rynku dostępnych jest wiele rozwiązań, takich jak Google Optimize, Optimizely, VWO czy Adobe Target. Przy wyborze uwzględnij:

- Intuicyjność interfejsu – czy jesteś w stanie szybko przygotować warianty stron.

- Możliwości zaawansowanej segmentacji i personalizacji.

- Integrację z innymi narzędziami analitycznymi.

- Koszt licencji w odniesieniu do wielkości ruchu na stronie.

Przeprowadzanie testów i zbieranie danych

Gdy plan jest gotowy, można przystąpić do wdrożenia eksperymentu. Kluczowe zasady:

Losowość i reprezentatywność

Użytkownicy powinni być przydzielani do grup A i B w sposób losowy, tak by obie grupy były porównywalne pod względem statystycznym. Unikaj sytuacji, w której wszystkie testy trafiają do osób logujących się o tej samej porze dnia.

Minimalny rozmiar próby

Aby uzyskać wiarygodne wyniki, liczba uczestników powinna zapewnić odpowiednią moc testu. Zbyt mała próba może prowadzić do wyników losowych.

Okres trwania testu

Test powinien trwać wystarczająco długo, by uwzględnić zmienność ruchu w tygodniu oraz dniach. Zwykle rekomenduje się minimum jeden pełny cykl tygodniowy.

Zbieranie i przechowywanie danych

- Zadbaj o poprawne tagowanie wydarzeń w narzędziu analitycznym (np. Google Analytics, Matomo).

- Monitoruj wyniki na bieżąco, ale unikaj przedwczesnego zakończenia testu.

- Gromadź dane w formie liczbowej, aby móc je później poddać analizie statystycznej.

Analiza wyników i optymalizacja

Po zakończeniu testu przychodzi czas na interpretację wyników. Należy zadbać o rzetelną analizę, uwzględniającą czynniki zakłócające.

Statystyczna istotność

Sprawdź, czy różnica między wariantami jest istotna z punktu widzenia statystyki. Często przyjmuje się poziom ufności 95%, choć w zależności od branży można dostosować ten próg.

Identyfikacja źródeł błędów

- Niereprezentatywny ruch – np. testy wykonywane głównie przez zespół wewnętrzny.

- Sezony i wydarzenia zewnętrzne – święta, promocje, awarie serwerów.

- Błędy techniczne – wpływają na poprawność zbierania danych.

Wdrażanie zwycięskiego wariantu

Gdy dowiesz się, że wariant B przynosi lepsze rezultaty, wprowadź zmiany na stałe. Następnie możesz rozpocząć kolejny cykl testowy, skupiając się na innych elementach strony czy komunikatu.

Przykłady udanych testów i najlepsze praktyki

Śledzenie case studies to świetny sposób na uczenie się na przykładach. Oto kilka inspiracji:

Prosty przycisk czy większy baner?

Firma e-commerce zauważyła, że większy, kontrastujący baner z obietnicą darmowej dostawy poprawił konwersję o ponad 20%. Zwiększona była także świadomość promocji – więcej osób dodawało towar do koszyka.

Personalizacja treści

Serwis informacyjny zdecydował się na dynamiczną prezentację nagłówków w oparciu o preferencje czytelnika. Test A/B wykazał wzrost czasu spędzanego na stronie o 35% i zwiększenie liczby rejestracji do newslettera.

Optymalizacja formularzy

Jedna z firm B2B ograniczyła liczbę pytań w formularzu rejestracyjnym z 10 do 5. Mimo że zebrała mniej szczegółowych informacji, wynikowy współczynnik wysłania formularza wzrósł o 50%, a późniejsze uzupełnienia danych odbywały się w procesie onboardingowym.

Kluczowe wnioski

- Testy A/B eliminują domysły i pozwalają na optymalizację w oparciu o dane.

- Każdy test wymaga precyzyjnego planu, właściwej segmentacji i odpowiedniego okresu trwania.

- Statystyczna istotność jest niezbędna, by uniknąć fałszywych wniosków.

- Wykorzystuj case studies i ciągle ucz się od innych, jednocześnie dostosowując metody do specyfiki własnego biznesu.